Un mal de tête persistant ? Une éruption cutanée étrange qui vous inquiète depuis trois jours ? Le premier réflexe n’est plus de fouiller dans les méandres de Doctissimo, mais d’ouvrir ChatGPT. En quelques secondes, l’intelligence artificielle propose des pistes, rassure ou au contraire, sème l’angoisse. La promesse est séduisante : un médecin virtuel disponible 24h/24, gratuit, capable de répondre à vos questions les plus intimes sans jugement.

Mais peut-on réellement se fier à un algorithme pour sa santé ? Cette question n’est pas anodine. Elle touche au cœur même de notre rapport à la médecine, à l’information et à la technologie. Entre fascination pour les capacités de l’IA et inquiétudes légitimes sur sa fiabilité, où se situe la vérité ?

⚠️ Le verdict de l’expert en 30 secondesNON, ChatGPT ne remplace pas un médecin et ne peut pas poser de diagnostic fiable.

C’est un excellent outil d’orientation et de préparation à une consultation médicale, mais l’utiliser pour un autodiagnostic définitif est dangereux. Il lui manque l’essentiel : votre contexte médical complet, l’examen clinique approfondi et le jugement humain forgé par des années de pratique.

L’IA peut vous guider vers des pistes, mais seul un professionnel de santé peut confirmer un diagnostic et prescrire un traitement adapté.

Ce guide complet décortique pourquoi cette pratique est à la fois fascinante et risquée, et vous donne les clés pour utiliser l’intelligence artificielle intelligemment pour votre santé, sans mettre votre vie en danger.

📑 Sommaire rapide

🧠 Pourquoi l’autodiagnostic par IA est-il si séduisant ?

Commençons par comprendre l’attrait irrésistible de ChatGPT pour les questions de santé. Ce n’est pas un hasard si des millions de personnes se tournent vers l’IA avant même de décrocher leur téléphone pour appeler un médecin.

⏱️ L’immédiateté d’une réponse instantanéeVous avez mal. Maintenant. Pas dans trois jours. Or, obtenir un rendez-vous chez un généraliste peut prendre une semaine, voire davantage dans les déserts médicaux. ChatGPT, lui, répond en trois secondes. Cette instantanéité est un baume psychologique immédiat, même si la qualité de la réponse pose question.

🌍 L’accessibilité totale et gratuitePas besoin de carte Vitale, de rendez-vous, de déplacement ou de paiement. Vous êtes malade à 3h du matin ? ChatGPT est là. Vous êtes en vacances à l’étranger sans assurance ? ChatGPT ne vous facturera rien. Cette disponibilité permanente crée un sentiment de sécurité, même illusoire.

😶 L’absence de jugement et d’embarrasCertaines questions sont difficiles à poser à voix haute, même à un médecin. Des symptômes intimes, une suspicion d’infection sexuellement transmissible, des troubles psychologiques… Face à un écran, anonymement, sans regard qui vous scrute, la pudeur s’efface. L’IA ne jugera jamais vos choix de vie, vos négligences ou vos craintes irrationnelles.

Ces trois facteurs expliquent l’engouement massif. Mais ils ne garantissent en rien la pertinence médicale de ce que vous obtiendrez.

🤖 Les capacités réelles de ChatGPT en santé

Soyons honnêtes : ChatGPT n’est pas totalement inutile en matière de santé. Il possède des capacités réelles qui, bien utilisées, peuvent être précieuses.

Synthétiser l’information médicale complexe

Imaginez que votre médecin vous parle de « dysfonctionnement thyroïdien avec hyperthyroïdie subclinique ». Vous hochez la tête poliment, mais vous n’avez rien compris. De retour chez vous, vous interrogez ChatGPT. L’IA excelle à vulgariser des concepts médicaux ardus en langage accessible. Elle peut décomposer le jargon, expliquer les mécanismes physiologiques, vous aider à comprendre ce qui se passe dans votre corps.

Cette capacité de traduction entre le langage médical et le langage courant est loin d’être négligeable. La compréhension de sa pathologie améliore l’observance thérapeutique et réduit l’anxiété liée à l’inconnu.

Expliquer la terminologie médicale obscure

« Expliquez-moi ce qu’est une hyperleucocytose. » En quelques lignes claires, ChatGPT vous dira que c’est une augmentation anormale du nombre de globules blancs dans le sang, souvent signe d’infection ou d’inflammation. Simple. Direct. Éducatif.

Générer des questions pertinentes pour votre consultation

Vous avez rendez-vous chez le cardiologue après des douleurs thoraciques ? Demandez à ChatGPT : « Quelles questions dois-je poser à mon médecin concernant mes douleurs thoraciques ? » L’IA vous proposera une liste structurée : fréquence des douleurs, facteurs déclenchants, antécédents familiaux, traitements envisageables, examens complémentaires nécessaires.

Cette préparation optimise votre consultation et vous évite de ressortir du cabinet en ayant oublié de poser LA question qui vous taraudait. Un usage intelligent qui améliore le dialogue patient-médecin plutôt que de le remplacer.

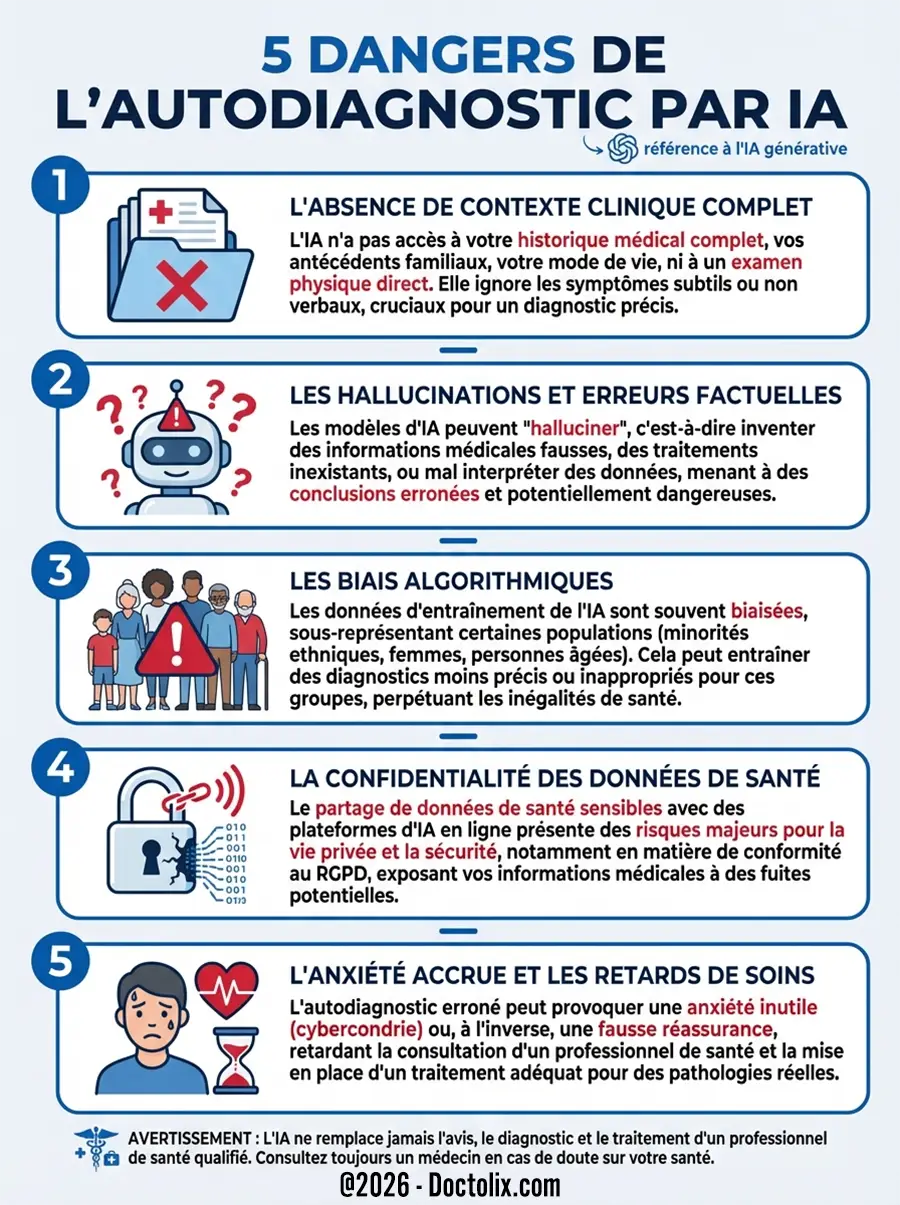

⚠️ Les 5 dangers de l’autodiagnostic par IA

Maintenant, entrons dans le vif du sujet. Les raisons pour lesquelles faire confiance aveuglément à ChatGPT pour un diagnostic médical peut avoir des conséquences graves, voire mortelles.

L’absence de contexte clinique complet

Voici le problème fondamental. ChatGPT ne vous connaît pas. Il ne connaît ni vos antécédents médicaux, ni vos traitements actuels, ni votre mode de vie, ni votre historique familial. Un symptôme isolé peut avoir des dizaines d’explications différentes selon le contexte.

Prenons un exemple concret : une fatigue chronique. Pour un adolescent en pleine croissance, c’est possiblement banal. Pour une femme de 40 ans avec des règles abondantes, ça peut signaler une anémie ferriprive. Et pour un homme de 60 ans fumeur, ça pourrait être le signal d’alerte d’un cancer pulmonaire débutant. Même symptôme, trois diagnostics radicalement différents.

ChatGPT ne peut pas faire cet examen clinique que réalise un médecin. Il ne peut pas ausculter vos poumons, palper votre abdomen, examiner l’aspect de votre peau, mesurer votre tension artérielle. La médecine n’est pas qu’une science de l’information, c’est aussi une science de l’observation directe.

Les « hallucinations » et les erreurs factuelles

Parlons d’un phénomène redoutable : les hallucinations de l’IA. Ce terme technique désigne le moment où ChatGPT invente des informations qui semblent parfaitement plausibles, cohérentes, rédigées avec assurance… mais totalement fausses.

L’IA peut citer des médicaments qui n’existent pas, des études scientifiques fictives, des protocoles de traitement dangereux. Et le pire ? Elle le fait avec une telle conviction que vous n’aurez aucune raison de douter. Un médecin formé pendant dix ans reconnaît ses zones d’incertitude. ChatGPT, lui, peut mentir avec aplomb sans s’en rendre compte.

Ces erreurs ne sont pas anecdotiques. Elles peuvent conduire à des décisions catastrophiques : retarder une consultation urgente, prendre un médicament contre-indiqué, minimiser un symptôme grave.

Les biais algorithmiques dans les données médicales

L’intelligence artificielle apprend sur des données existantes. Or, ces données reflètent les biais de notre société. La recherche médicale a historiquement sous-représenté les femmes, les minorités ethniques et les populations âgées dans ses études.

Résultat ? ChatGPT peut mal interpréter des symptômes spécifiques à certaines populations. Les crises cardiaques chez les femmes se manifestent souvent différemment que chez les hommes (nausées, fatigue extrême plutôt que douleur thoracique classique). Une IA entraînée majoritairement sur des cas masculins pourrait passer à côté de ces nuances cruciales.

La confidentialité de vos données de santé

Chaque fois que vous décrivez vos symptômes à ChatGPT, vous transmettez des données de santé personnelles. Que deviennent-elles ? Sont-elles anonymisées ? Stockées ? Utilisées pour entraîner de futures versions du modèle ? La CNIL, autorité française de protection des données, a d’ailleurs publié un plan d’action spécifique sur l’intelligence artificielle pour encadrer ces usages.

Vos données de santé sont parmi les plus sensibles qui existent. Les confier à un outil commercial dont le modèle économique repose sur l’exploitation de données pose des questions éthiques et juridiques majeures. En Europe, le RGPD impose des garde-fous stricts, mais leur application concrète aux IA conversationnelles reste un chantier en cours.

Heureusement, pour éviter ces écueils et gérer ses informations médicales en toute confiance, un écosystème sécurisé existe. L’État et l’Assurance Maladie ont en effet développé des applications santé certifiées qui, elles, respectent un cahier des charges très strict en matière de protection des données.

Le faux réconfort ou l’anxiété inutile

ChatGPT peut vous tuer de deux manières opposées. D’abord, en minimisant un symptôme grave. « Ces douleurs thoraciques sont probablement du stress. » Vous vous sentez rassuré. Vous ne consultez pas. Trois jours plus tard, c’était un infarctus. Le retard de diagnostic peut transformer une pathologie traitable en catastrophe irréversible.

À l’inverse, l’IA peut créer une panique injustifiée. Vous tapez « mal de tête + vision floue » et ChatGPT évoque la possibilité d’une tumeur cérébrale. Vous passez trois jours d’angoisse absolue avant qu’un médecin ne diagnostique une simple migraine ophtalmique sans gravité.

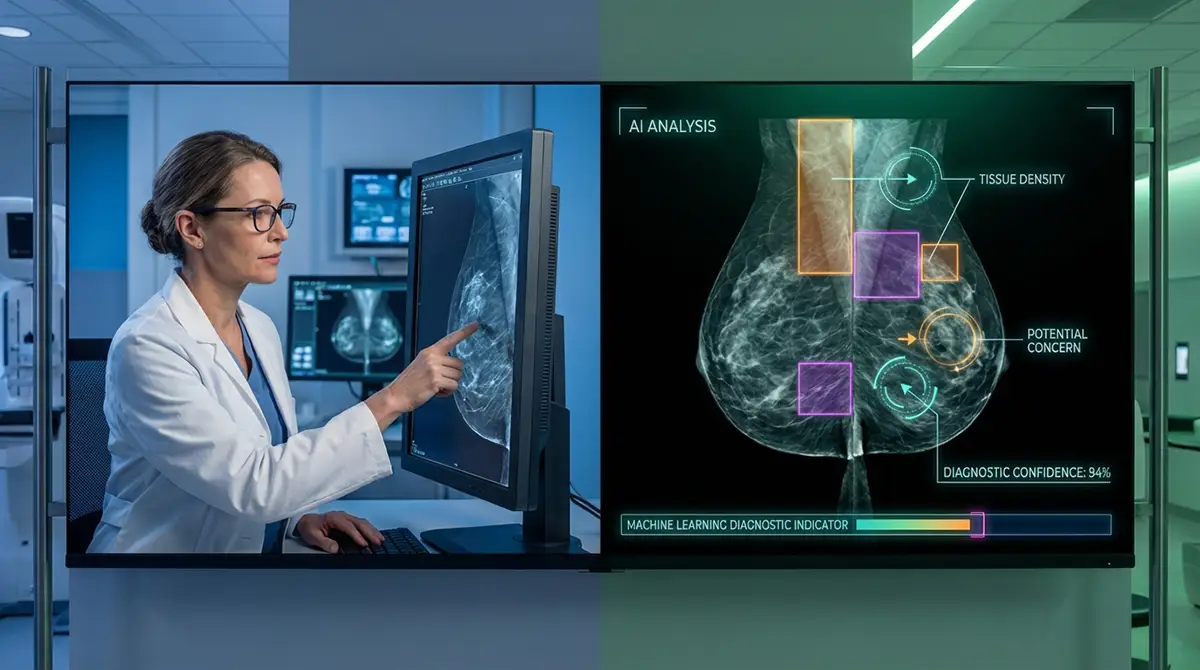

📈 Quand l’IA fait des progrès spectaculaires : les cas d’usage validés

Avant de conclure que l’IA n’a aucune place en médecine, nuançons. Des progrès spectaculaires existent, mais dans des cadres très spécifiques et contrôlés.

Selon un article du journal Le Monde, l’intelligence artificielle commence à « raisonner comme un médecin » dans certains contextes diagnostiques précis. Mais cette capacité reste encore expérimentale et nécessite une supervision médicale constante.

Plus impressionnant encore : l’IA montre des résultats prometteurs dans le dépistage du cancer du sein. Selon La Dépêche, l’IA peut identifier les femmes à risque jusqu’à six ans avant le diagnostic conventionnel. Le dépistage assisté par algorithme permet d’augmenter de 17,6% la détection des cas, avec 6,7 cancers détectés pour 1000 femmes contre 5,7 avec les méthodes traditionnelles. Les chercheurs soulignent que cette aide au diagnostic réduit également le nombre de faux positifs.

Ces avancées sont réelles et prometteuses. Mais notez la nuance fondamentale : il s’agit d’aide au diagnostic, pas de remplacement du médecin. L’IA analyse des mammographies sous supervision médicale, elle ne remplace pas l’expertise humaine.

D’ailleurs, l’Organisation mondiale de la santé (OMS) a publié des recommandations claires appelant à un usage sûr et éthique de l’IA en santé, insistant sur la nécessité d’une régulation stricte et d’une supervision humaine constante.

En France, la Haute Autorité de Santé a également pris position sur le sujet. Dans un document de cadrage, elle reconnaît le potentiel de l’IA générative en santé, mais uniquement « avec un usage responsable » et dans un cadre strictement encadré. Les autorités sanitaires sont unanimes : l’IA est un outil, jamais un substitut au jugement médical.

🩺 Le verdict de l’expert : comment utiliser ChatGPT intelligemment pour sa santé

Maintenant que vous comprenez les capacités et les limites de l’IA, voici un guide pratique pour l’utiliser sans danger.

| ✅ À faire (utilisation intelligente) | ❌ À ne pas faire (utilisation dangereuse) |

|---|---|

| Pour comprendre un terme médical complexe que votre médecin a utilisé | Pour obtenir un diagnostic définitif sur vos symptômes |

| Pour lister des questions pertinentes à poser lors de votre prochaine consultation | Pour remplacer complètement une consultation médicale |

| Pour synthétiser des informations générales sur une pathologie connue | Pour interpréter vos résultats d’analyse sanguine ou d’imagerie |

| Pour des conseils de bien-être non médicaux (nutrition, exercice général) | Pour choisir un traitement, un médicament ou un dosage |

| Pour traduire un compte-rendu médical en langage simple | Pour diagnostiquer une maladie grave ou rare |

| Pour préparer une discussion avec votre pharmacien | Pour décider si vous devez ou non consulter aux urgences |

Ce tableau devrait devenir votre boussole. Dès que vous franchissez la ligne rouge vers la colonne de droite, vous mettez votre santé en danger.

Les signaux d’alarme qui nécessitent une consultation immédiate

Certains symptômes ne tolèrent aucun délai, aucune consultation virtuelle, aucun autodiagnostic. Si vous présentez l’un de ces signes, raccrochez avec ChatGPT et composez le 15 (SAMU) :

- Douleur thoracique intense, surtout si elle irradie vers le bras gauche ou la mâchoire

- Difficulté respiratoire sévère ou brutale

- Perte de conscience ou malaise avec confusion mentale

- Douleur abdominale aiguë et intense

- Hémorragie importante qui ne s’arrête pas

- Maux de tête violents et inhabituels, surtout accompagnés de raideur de nuque

- Paralysie soudaine, même partielle

- Trouble de la parole ou de la vision apparu brusquement

Face à ces situations, chaque minute compte.

ChatGPT ne remplacera jamais l’urgence d’une prise en charge médicale immédiate.

Comment formuler une bonne question à ChatGPT (pour un usage sûr)

Si vous décidez malgré tout d’utiliser ChatGPT pour une question de santé, au moins faites-le intelligemment. Voici comment formuler vos demandes pour obtenir des informations utiles sans tomber dans le piège de l’autodiagnostic hasardeux :

❌ Mauvaise question : « J’ai mal à la tête depuis trois jours, c’est quoi ? »

✅ Bonne question : « Quelles sont les causes les plus courantes de maux de tête persistants, et quels signaux d’alerte justifieraient une consultation rapide chez un médecin ? »

Vous voyez la différence ? La première demande un diagnostic. La seconde demande une éducation qui vous aidera à prendre une décision éclairée sur la nécessité de consulter.

❓ Foire aux questions

ChatGPT est-il formé sur des données médicales fiables ?

ChatGPT est entraîné sur une vaste quantité de textes disponibles sur internet, incluant des publications médicales, des articles scientifiques, mais aussi des forums de discussion, des blogs de santé plus ou moins sérieux. Il n’a pas accès en temps réel aux bases de données médicales officielles et ses connaissances s’arrêtent à sa date de coupure d’entraînement. Il ne connaît pas les dernières découvertes, les nouveaux traitements, les alertes sanitaires récentes. Un médecin se forme continuellement. ChatGPT, lui, fige son savoir à un instant T.

Les médecins utilisent-ils l’IA pour leurs diagnostics ?

Oui, de plus en plus, mais dans un cadre très différent de votre usage de ChatGPT. Les médecins utilisent des IA médicales spécialisées, validées cliniquement, conçues spécifiquement pour l’aide au diagnostic. Ces outils analysent des données structurées (imageries médicales, résultats biologiques) et proposent des hypothèses que le médecin valide ou infirme avec son expertise. L’IA est un assistant, le médecin reste le décideur final. C’est fondamentalement différent d’un patient qui consulte seul ChatGPT sans supervision médicale.

Les informations de santé que je donne à ChatGPT sont-elles protégées ?

La réponse courte : pas autant que chez votre médecin. Les échanges avec votre médecin sont couverts par le secret médical, un principe juridique absolu. Les conversations avec ChatGPT relèvent des conditions générales d’utilisation d’OpenAI, beaucoup moins protectrices. Vos données peuvent être stockées, analysées, utilisées pour améliorer le modèle. Même si OpenAI affirme prendre la confidentialité au sérieux, ce n’est pas comparable au secret médical. Si vous devez absolument utiliser ChatGPT pour une question de santé, restez vague, n’incluez jamais vos informations personnelles identifiantes.

Existe-t-il d’autres IA plus fiables pour la santé ?

Oui. Des IA médicales spécialisées existent, développées par des institutions médicales, validées cliniquement. Mais elles ne sont généralement pas accessibles au grand public. Elles sont réservées aux professionnels de santé dans un cadre diagnostique précis. Pour le grand public, la seule IA médicale fiable reste celle qui est supervisée par un vrai médecin. Autrement dit, votre médecin qui utilise des outils d’aide au diagnostic.

📌 Conclusion

ChatGPT est un formidable assistant d’information médicale, mais un très mauvais médecin. Cette phrase résume tout. L’outil peut vous aider à préparer votre consultation, à comprendre les explications de votre médecin, à vous éduquer sur une pathologie. Mais il ne doit jamais, jamais remplacer un avis médical professionnel.

La tentation est compréhensible. L’immédiateté, la gratuité, l’absence de jugement… tout cela rend ChatGPT irrésistible. Mais votre santé ne mérite pas un diagnostic approximatif généré par un algorithme qui ne vous connaît pas, ne peut pas vous examiner et peut halluciner des informations dangereuses.

Votre santé est votre bien le plus précieux. Pour toute question médicale, le seul réflexe sûr et fiable reste le même qu’il y a cinquante ans : consultez un professionnel de santé. Un médecin généraliste, un spécialiste, un pharmacien, une infirmière. Des humains formés, réglementés, responsables de leurs actes.

✅ Message clé : L’intelligence artificielle transformera la médecine, c’est certain. Mais elle la transformera en outil d’aide au diagnostic pour les médecins, pas en remplacement du lien patient-soignant. Ce lien humain, fait d’écoute, d’expérience, de jugement clinique et d’empathie, reste irremplaçable.Alors oui, utilisez ChatGPT pour vous informer. Mais ne lui confiez jamais votre vie.